Der ENTER Online eignet sich sowohl um die Trainings- und Testphase des Entscheidungsbaum-Algorithmus als Beispiel eines Algortihmus maschinellen Lernens durchzuführen, als auch um den Einfluss von Trainingsdaten und Hyperparametern auf die Zuverlässigkeit der Ergebnisse des Algorithmus zu untersuchen.

Daten in den ENTER laden

Zu Beginn müssen Daten in Form einer CSV-Datei in den ENTER geladen werden. Nachfolgend finden Sie einige von uns zur Verfügung gestellte Datensätze.

-

📑 Trainingsdatensatz_Fische_klein als .csv-Datei:Download ⭳

-

📑 Testdatensatz_Fische_klein als .csv-Datei:Download ⭳

-

📑 Fischdatensatz_groß als .csv-Datei:Download ⭳

Es können auch eigene Datensätze in den ENTER geladen werden. Diese müssen in der ersten Zeile die

Benennungen der betrachteten Merkmale und die Benennung der

Labelspalte enthalten. In den folgenden Zeilen stehen nun die Werte der einzelnen

Trainingsdatenpunkte entsprechend der

festgelegten Reihenfolge der Merkmale. Die einzelnen Einträge müssem mit ; getrennt sein.

Den Entscheidungsbaum erstellen

Nachdem Daten für das Training des Entscheidungsbaums geladen wurden, kann dieser mit nur einem Klick erstellt werden. Zuvor können noch das zu verwendende Splitkriterium und optional gewünschte Hyperparameter ausgewählt werden.

Im Bereich Informationsgewinn können Sie das Split-Kriterium auswählen, welches für die Bestimmung des besten Attributs, also die Berechnung des Informationsgewinns, verwendet wird. Zur Auswahl stehen die Splitkriterien Fehlklassifikationen zählen, Fehlklassifikationsrate, Gini-Impurity und Entropie. Da an diser Stelle der Fokus auf der Anwendung des ENTERs liegt, wird für die fachliche Erklärung der Splitkriterien auf die ISB-Handreichung Künstliche Intelligenz oder auf die Fortbildungen KI@Informatik 11 – was, wozu, wie, womit unterrichten der Universität Passau verwiesen.

Im Bereich Hyperparameter können Sie unterschiedliche Hyperparameter festlegen, welche bei

der Erstellung des

Entscheidungsbaums berücksichtigt werden sollen

Verfügbare Hyperparameter:

- Maximale Baumtiefe:

Dieser Hyperparameter bestimmt die maximale Tiefe des Entscheidungsbaums. Ist der Hyperparameter aktiv mit eingetragenem Wert 5, hat der erstellte Baum eine maximale Baumtiefe von 5. Ein Baum mit Tiefe 0 besteht nur aus der Wurzel.

Als Eingabe sind nur nicht-negative, ganze Zahlen zugelassen. - Minimale Reinheit in % für Klassifikation:

Dieser Hyperparameter bestimmt die minimale Reinheit eines Knoten in Prozent, welche dieser mindestens haben muss, damit er nicht weiter aufgeteilt, d.h. einer Klasse zugeordnet wird. Ist der Hyperparameter aktiv mit eingetragenem Wert 60, wird ein Knoten einer Klasse zugeordnet, d.h. nicht weiter aufgeteilt, wenn mindestens 60 % seiner Trainingsdaten zu der im Knoten maximal vorkommenden Klasse gehören. Andernfalls wird weiter aufgeteilt.

Als Eingabe sind nur nicht-negative, ganze Zahlen im Bereich von 1 bis 100 zugelassen. - Minimale Elementzahl in Knoten:

Dieser Hyperparameter bestimmt die minimale Anzahl an Trainingsdatenpunkten, welche der zu einem Knoten gehörende Teildatensatz haben muss für eine weitere Aufteilung. Ist diese minimale Anzahl unterschritten, findet keine weitere Aufteilung des Knotens statt. Ist der Hyperparameter aktiv mit eingetragenem Wert 5, wird ein Knoten nur aufgeteilt, wenn der zum Knoten gehörende Trainingsdatensatz aus 5 oder mehr Elementen besteht.

Als Eingabe sind nur positive, ganze Zahlen größer gleich 1 zugelassen.

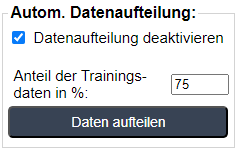

Durch Auswahl der Checkbox im Bereich Autom. Datenaufteilung wird der Teil der Oberfläche

zur Steuerung der automatischen Datenaufteilung eingeblendet (siehe links).

Die Eingabe im Feld Anteil der Trainingsdaten in % legt fest, wie viele Datenobjekte (Anzahl

aufgerundet)

des geladenen Datensatzes entsprechend dem eingegebenen Prozentsatz als Trainingsdaten verwendet

werden sollen.

Durch Klick auf den Button Daten aufteilen werden die geladenen Daten gemischt und aufgeteilt

in Trainingsdaten

und Testdaten. Da sich damit die Trainingsdaten geändert haben, wird ein ggf. trainierter

Entscheidungsbaum verworfen.

Der auf die Trainingsdaten entfallende Teildatensatz wird im Tab Trainingsdaten angezeigt.

Der auf die

Testdaten entfallende Teildatensatz wird im Bereich des Testmodus hinterlegt.

Deaktiviert man die automatische Datenaufteilung stehen wieder alle geladenen Daten als

Trainingsdaten zur Verfügung.

Knotendetails - Den Baum unter die Lupe nehmen

Durch Klick auf einen Knoten des Entscheidungsbaums werden im Reiter Knotendetails die Informationen zu diesem Knoten angezeigt.

Je nach Art des ausgewählten Knoten ändert sich die Anzeige.

- Auswahl eines inneren Knotens:

Anzeige der durch eine potentielle Aufteilung nach dem jeweiligen Attribut erreichten Informationsgewinne, des dadurch ausgewählten besten Attributs für eine Aufteilung und des Teildatensatzes des Knotens. - Auswahl eines Blattknotens:

Anzeige des Teildatensatzes des Knotens.

Testmodus - Den Entscheidungsbaum testen

Nachdem im Rahmen der Trainingsphase ein Entscheidungsbaum erstellt wurde, kann dieser nun auch direkt im ENTER getestet werden. Dafür lässt sich ein Testdatensatz mit Hilfe des Baums auswerten und die Ergebnisse dieser Auswertung werden, sowohl direkt, als auch zusammengefasst in Form einer Konfusionsmatrix dargestellt (siehe nächsten Abschnitt).

Wird der Testmodus durch Klick auf den Button Testmodus aktivieren aktiviert,

werden alle für das Training nutzbaren

Eingabemöglichkeiten deaktiviert, damit während des Testens das Modell nicht geändert werden kann.

Des Weiteren wird der

Tab aktiviert, welcher den Testmodus realisiert.

Wird der Testmodus durch Klick auf den Button Testmodus deaktivieren

deaktiviert, werden alle Berechnungen der aktuellen

Testphase verworfen, die entsprechenden Tabs werden deaktiviert und die Eingabemöglichkeiten für die

Trainingsphase werden wieder aktiviert.

Konfusionsmatrix - Informationen zum Testvorgang

In diesem Tab werden detailiertere Informationen angezeigt. Neben der Konfusionmatrix, in welcher die Ergenbisse des Testvorgangs für den aktuellen Testdurchlauf dargestellt sind, wird das Gütemaß Genauigkeit berechnet. Dieses ergibt sich als der Anteil der korrekt klassifizierten Testdatenobjekte an allen Testdatenobjekten.

Allgemeine Informationen

An dieser Stelle liegt der Fokus auf der Anwendung des ENTERs. Für weitere fachliche Informationen empfiehlt sich die Lektüre der ISB-Handreichung Künstliche Intelligenz oder die Teilnahme an den Fortbildungen KI@Informatik 11 – was, wozu, wie, womit unterrichten der Universität Passau. Detailiertere Informationen zu den Funktionen des ENTERs finden Sie im Handbuch zur Offline-Version des ENTscheidungsbaum-ERstellers.

ENTER Online läuft in aktuellen Browsern (getetstet mit Chrome und Edge) und wurde in

Javascript entwickelt.

Für die Berechnung des Baumlayouts und die grafische Darstellung des Entscheidungsbaums

wurde D3.js

(https://d3js.org/; Source-Code steht

unter

ISC-Lizenz)

als Thirdparty-Komponente verwendet.

Die Nutzung von ENTER Online erfolgt auf eigenes Risiko. Der Autor ist nicht für Fehler oder

Folgen, die aus der Verwendung von ENTER Online resultieren, haftbar zu machen.

Es wird keine Haftung für irgendwelche Schäden übernommen, die in Zusammenhang mit

dieser Software entstehen. Ebenfalls werden keine Garantien bezüglich der Funktionsfähigkeit

oder Korrektheit der Software gegeben.